Обзор книги «Сигнал и Шум»

Нейт Сильвер — автор «Сигнала и Шума» — широко известен благодаря своим удачным прогнозам, например, выборов в США. Неудивительно, что книга стала бестселлером.

Собственно, прогнозам книга и посвящена: подходам к прогнозированию, сложностям, ошибкам, заблуждениям и так далее.

Как обычно, я рассчитывал на более теоретическое изложение, в духе Масштаба, но автор выбрал другой путь и подаёт свои идеи через разбор конкретных случаев: один случай на главу. Каждая глава описывает большую задачу, например, предсказание погоды, и с помощью неё даёт несколько призм для взгляда на прогнозирование. Это определённо делает материал доступнее, но лично я хотел бы больше системности и теории.

Из-за подхода через изложение кейсов, сделать краткую выдержку из книги сложно. Это возможно, было бы даже интересно попробовать, но объём работы слишком большой — автор не ставил целью свести всё в цельную систему или короткий набор тезисов.

Поэтому дам отзыв на книгу в целом, примерный перечень призм и набор прикольных фактов.

Мои GPT-шки и prompt engineering

Понечки занимаются prompt engineering (c) DALL-E

Я пользуюсь ChatGPT практически с момента выхода её четвёртой версии (то есть уже больше года). За это время хорошо набил руку в написании запросов к этой штуке.

В какой-то момент, OpenAI разрешили настраивать свой чат с помощью собственных текстовых инструкций (ищите Customize ChatGPT в меню). Я постепенно дописывал туда команды и вот на днях размер инструкций превысил разрешённый максимум :-)

Плюс, оказалось, что универсальный набор инструкций не получается — под каждую задачу их нужно подстраивать, иначе они не будут так полезны как могли бы быть.

Поэтому покумекав, я решил вместо кастомизации своего чата, вынести инструкции в GPT ботов. OpenAI называют их GPTs, по-русски буду называть их GPT-шками. По-сути, это такие же чаты, в которых больше лимит на кастомизированные инструкции и в них можно залить дополнительные тексты как базу знаниий.

Когда-нибудь, я сделаю GPT-шку для этого блога, а пока расскажу про двух рабочих лошадок, которыми пользуюсь каждый день.

- Expert — ответы на вопросы.

- Abstractor — краткое изложение текста.

Для каждой будет описание базового промпта с моими комментариями.

OpenAI недавно открыла магазин GPT-шек, буду благодарен если пролайкаете мои. Конечно, только если они вам полезны.

О книге «Сеть и бабочка»

«Сеть и бабочку» я купил по ошибке, когда лет 5 назад был в Питере и устроил день книжных. Набрал килограмм 10 книг :-D, эту захватил по инерции, не вчитавшись в содержание. Думал, книга будет о сетевом эффекте и распространении идей, а оказалось она о том, как «управлять» мозгом, опираясь на одну из нейронных сетей в нём. На какую? Для книги и её содержания не имеет никакого значения.

Мнение моё о «Сети и бабочке» двоякое. С одной стороны не могу отказать ей в полезности, с другой… можно было подать материал в 100 раз лучше и в 3 раза короче. Местами авторы ходят по тонкому льду и рискуют провалиться в инфоцыганство.

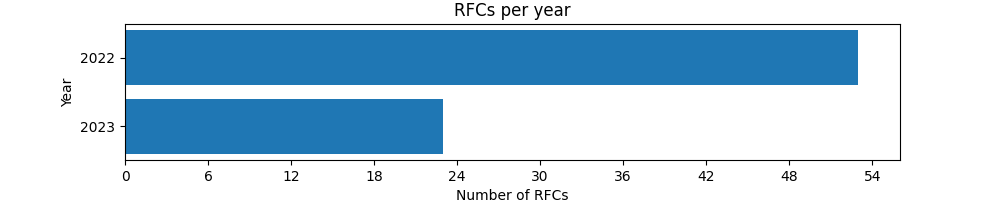

Два года пишем RFC — статистика

Два года как я Lead/Engineering Manager в платёжке Palta. А на следующей неделе я ухожу из компании в очередной творческий отпуск.

Время подводить итоги. Начну с моей самой любимой инициативы.

С первого месяца я начал продвигать идею предварения крупных изменений текстовыми документами — RFC — Request for Comments.

В этом посте будет анализ двух лет применения этой практики. Чтобы пошарить опыт, подвести итоги и иметь под рукой агитку для моего следующего места работы.

Paul Graham: Superlinear returns

(c) DALL-E: "Vrubel painting of a blogger crying with admiration while reading an essay by another, more experienced, author." DALL-E отказывается рисовать по запросам с именами.

Рекомендую эссе Paul Graham: Superlinear returns.

Что мне нравится в текстах Paul Graham так это опережение моих писательских планов. Пол периодически пишет про то, что я давно хочу написать, но пока не могу — ещё не Paul Graham :-D

Конкретно на тему нелинейных изменений я уже лет 10 хочу написать эссе да побольше. Но если бы я сел его писать сейчас, то это был бы длиннопост со странными графиками и терминами и без таких интересных примеров как у Пола. Поэтому приходится давать ссылки на его эссе.

Дальше, в общем-то, можете мой пост не читать. Главное оригинальное эссе прочтите. Но оставлю пару заметок для истории, которые лучше читать после оригинального эссе.