Больше новостей о процедурной генерации

Примеры генерации 3D модели по запросу "A capybara made of voxels sitting in a field"

На этот раз Open AI рассказали о новой нейронке (на русском) а-ля GPT-3, но для изображений. Пример её работы можно видеть на заглавной картинке. Изображения сформированы для фразы «A capybara made of voxels sitting in a field» (капибара из вокселей, которая сидит в поле).

На странице с анонсом можно посмотреть другие примеры работ, включая разные способы изображения (3D рендер, изометрию, низкополигональные модели, etc).

Результаты, конечно, кривоваты. Но, надо учесть два нюанса:

- Это первый подход к подобной архитектуре с подобными деньгами.

- Это сеть общего назначения, не натасканная на геймдев.

А вот если бы её допилить, специализировать на фэнтези, да подключить к Сказке… Но у меня столько денег нет :-) А у кого-нибудь обязательно найдутся.

Постепенно вырисовывается новый пайплайн для арта:

- нейронка для постановки задания;

- нейронка для генерации контента;

- нейронка для устранения неточностей на картинке;

- нейронка для стилизации;

- нейронка для вылизывания;

- нейронка для выделения 3D меша;

- нейронка для оптимизации меша;

- нейронка для анимации;

Интеграция контента, позиционирование камер, цвет, свет, звук и прочее — тоже нейронки. Ну вы поняли :-D

Товарищи, которые научатся делать эти лопаты, сорвут большой куш.

Итоги 2020 года для меня и блога

](https://tiendil.org/static/posts/results-of-2020-for-me-and-the-blog/images/results-of-2020-for-me-and-the-blog-cover.jpg)

Расскажу чем занимался весь год, сколько чего прочитал, сколько написал, какие посты считаю лучшими и что планирую на год следующий.

Поругайте (или похвалите) меня

Но лучше всё-таки поругайте. Похвалить я и сам могу ;-)

Бложику нужна обратная связь от читателей.

Мне нравится как он изменился за последний год: посерьёзнел, обрёл некоторую самобытность. Как мне кажется. Подробнее об этом я постараюсь рассказать в отдельном посте.

А, и самое главное — блог читают о_О Привет читатели!

Чтобы и мне и бложику развиваться дальше, необходимо исправлять слабые места и находить новые возможности. Некоторые вещи я вижу, но определённо не все и не в том свете, в котором видите вы.

Поэтому я буду очень благодарен за пару слов с критикой или советами от вас мне:

- как сделать бложик лучше;

- как не сделать хуже;

- о чём писать, о чём не писать;

- и так далее…

Пишите где вам удобно: в комментариях к посту, в телеграмме, в facebook, на почту, etc.

Заодно, принимаю заказы на посты. Пишите интересующие вас темы, постараюсь их раскрыть, если получится :-)

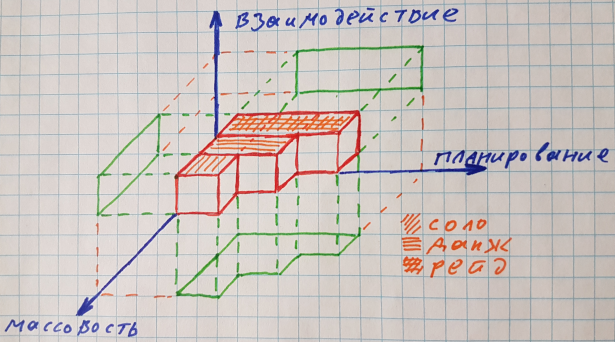

Пространство механик ММО

Примерная иллюстрация идеи. Направления осей можно выбирать произвольно.

Рисовал своей рукой. Старался :-D

Давно крутил в голове формальный подход к выбору механик для ММО, но чего-то не хватало. Спасибо дискуссии на mmozg.net — нашёл недостающую размерность.

Идея в следующем.

Чтобы игра была долго интересна целевой аудитории, её механики должны закрывать некоторый набор потребностей игроков.

Самый простой пример — психотипы Бартла. Планируя механики для игры, необходимо позаботиться, чтобы они закрывали потребности каждого психотипа. В идеале. То есть нужны механики для achievers, killers, socializers и explorers. Не обязательно по одной на каждый тип. Можно по несколько, а можно и так, чтобы одна механика закрывала несколько типов.

Но психотипы относятся в первую очередь к игрокам, а не к самим механикам. В конце концов возможна игра только для исследователей, почему бы ей не быть?

Мне же интересно посмотреть на сами механики, динамику игры и именно в контексте ММО. Безотносительно свойств самих игроков.

Поэтому я попробовал представить игровые механики как объекты в многомерном пространстве (механик) и выделить в этом пространстве ортогональные оси.

Математики добрались до нейронных сетей

На arxiv.org выложен интересный препринт: Every Model Learned by Gradient Descent Is Approximately a Kernel Machine.

Как видно из названия, исследователи утверждают, что нейронные сети, обученные методом градиентного спуска (один из самых распространённых вариантов обучения) близки такой штуке как kernel machines — одной из техник машинного обучения «предыдущего поколения».

У kernel machines есть несколько интересных особенностей:

- Техника хорошо проработана математически.

- Требует значительно менее дорогих вычислений.

- Вместо «выделения» признаков «напрямую» использует обучающую выборку.

Из этого может неслучиться несколько интересных вещей.

- «Готовая» математика упростит сети и/или улучшит их результат и/или ускорит/удешевит обучение.

- Область возможностей сетей очертится более чётко — окажется, что они не выделяют никакие новые признаки, а используют только «запутанные» данные из обучающей выборки.

Оба варианта выглядят довольно интересно.