Kaggle: Digit Recognizer (MNIST) точность 0.99585

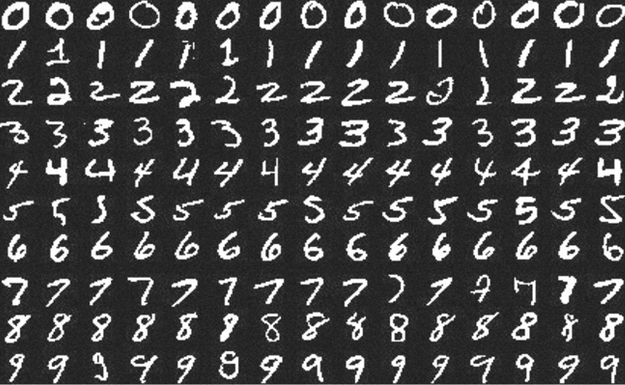

Примеры цифр из набора MNIST.

Продолжаю путешествие по занимательным землям Deep Learning.

В прошлый раз я учился заводить deep learning на локальной машине и делал совсем детскую, искусственную и неспецифическую для DL задачу.

В этот раз решил попробовать что-то более диплёрничное — научиться решать задачи на Kaggle. Есть предположение, что Kaggle — самый простой и интересный способ учить DL.

На этом сервисе есть задачи для новичков, одну такую — Digit Recognizer — я выбрал для тренировки. Соревнование по распознаванию рукописных цифр из набора MNIST. Этот набор должны были встречать даже люди далёкие от ML.

Notebook с решением и комментариями опубликован на github.

На момент отправки решение занимало 467 место из ~7000. На мой взгляд неплохой результат, учитывая, что первые мест 150 занимают читерские решения. MNIST — общедоступный набор данных, их можно скачать вне kaggle и залить в качестве решения готовые ответы, или переобучить сеть на полном наборе.

Нельзя просто так взять и запустить Deep Learning

Продолжаю разбираться с Deep Learning.

Решил попробовать его на практике: сам придумал лабу, сам сделал, сам себя похвалил.

Целью было построить простейшую, но более-менее полную цепочку обучения модели с помощью Keras+TensorFlow и запустить её на своей машине.

Публикую notebook с выполненной лабой, комментариями о базовых штуках, костылях и нюансах. Надеюсь, будет полезна новичкам. Может быть меня даже поругает кто-нибудь из опытных датасаентистов.

А в этом посте покритикую инфраструктуру всего этого.

Подписал письмо в поддержку Столлмана

Подробно описывать ситуацию не буду — она много где уже разжёвана. Начать раскопки можно с хабра.

Само письмо: https://rms-support-letter.github.io/

Подробнее о письме на русском, с толикой теории заговора.

Русскоязычная GPT-2+ от Сбера vs «Сказка»

Сбер выпусти свой генератор текста, основанный на GPT-2. Я попробовал скормить ему сказочные описания действий героев. Проверял на jupiter note, опубликованной в вебе, так что вы тоже можете с ней поиграть.

Обновлено: говорят, использовали на GPT-3, а GPT-2 с доработками.

Получилось средненько — не на тех текстах всё-таки нейронка обучалась. Вот если бы ей фэнтези скормили… Текст получается осмысленный, но чувствуется явная нехватка контекста.

Самые интересные примеры под катом.

Этика передачи знаний

Недавно мне на глаза попалась пара платных курсов. Один по Python (с примечательной программой), другой по саморазвитию. Оба хорошо сделаны с точки зрения маркетинга, я бы сказал на высоте. И оба, скорее всего, разводилово. Как минимум на уровне взятия денег за то, что можно получить бесплатно.

В тему будет вспомнить и обилие курсов тематики «войти в IT», большинство которых не даёт никакой гарантии.

Подобные курсы пиарятся по лучшим методичкам, из-за чего сложно объяснить неподготовленному человеку в чём подвох. А иногда надо. Поэтому я попробую зайти с другой стороны.

Вместо копания в конкретных курсах, поставлю под сомнение саму концепцию передачи знания за деньги.