Как завалить собес у меня

Мы в Palta активно ищем сотрудников, поэтому я собеседую людей уровня senior & lead. А до этого в Melsoft доводилось мидлов и выше собеседовать. Накопился ряд наблюдений, которыми хочется поделиться.

Сначала хотел написать на глобальную тему, вроде разницы между junior, middle, senior & lead, но дело шло туго, поэтому сделаю проще.

Расскажу о косяках, которые с большой вероятностью помешают пройти собеседование конкретно у меня.

По отдельности каждая проблема — не приговор, но точно снижает шансы на положительное впечатление.

Для каждой проблемы я написал упрощённый пример диалога. Надеюсь получилось наглядно. Главное помните, что вопросы и ответы там придуманы специально для иллюстрации проблемы, а не взяты из реальных собесов. По большей части :-)

Ищу людей в команду

Мы хайрим (Python backend, QA automation, Android) и релоцируем (Польша, Кипр, и может быть ещё куда-то).

Делаем платформу для обработки платежей для стартапов Palta (включая Flo, в будущем). То есть много сложной работы с повышенными требованиями к качеству.

Попутно надо будет писать RFC (Requests For Comments), тесты (много), ревьювить код и, путём культурных дискуссий, передавать свои знания коллегам.

Пару месяцев как начали. Работаем удалённо. Ищем сеньоров и выше.

Технологии: AWS, Lambda, Aurora (PostgreSQL), последний поддерживаемый облаками Python.

Работать надо будет со мной в команде, со всеми плюсами и минусами этого :-DDD

Также, пока не ищем, но, надеюсь, будем: сильного фронтендера, технического-писателя-специалиста-по-dev-relations.

Ссылки с вакансиями:

https://boards.greenhouse.io/paltaltd/jobs/4467423004 https://boards.greenhouse.io/paltaltd/jobs/4383116004 https://boards.greenhouse.io/paltaltd/jobs/4459360004

Если нужны подробности, пишите в личку или в комментарии.

Если будете общаться с нашими рекрутёрами, упомяните где увидели вакансии :-)

Почему мне не нравится Rust

Во второй раз перелистал документацию Rust, прошлый заход случился лет 5 назад.

Думал, что-нибудь изменится в моём восприятии этого языка, но нет. Как и в прошлый раз, начинается всё хорошо — норм язык, а потом он начинает нравиться всё меньше и меньше.

И похоже я понял, что меня в нём задевает.

Реализация Generative Adversarial Network

В завершение разбирательства с Deep Learning решил посмотреть что-нибудь более интересное и ориентированное на генерацию контента — реализовать GAN.

По правде говоря, большую часть времени с GAN (и Autoencoder) я экспериментировал на спрайтах карты Сказки. Ожидаемо, на таком мизере обучающих данных ничего интересного не получилось. Хотя польза и была. Поэтому для поста я подготовил отдельный notebook с более наглядными результатами — генерацией обуви по набору данных Fashion MNIST.

Ноутбук с реализацией GAN и комментариями.

Про архитектуру GAN лучше почитать в вики, интернетах или моём ноутбуке.

Краткая суть:

- Тренируются две сети: generator & discriminator.

- Генератор учится создавать картинки из шума.

- Дискриминатор учится отличать поддельные картинки от настоящих.

- Ошибка дискриминатора определяется качеством предсказания фейковости изображения.

- Ошибка генератора определяется качеством обмана дискриминатора.

Если правильно подобрать топологии сетей и параметры обучения, то в итоге генератор научается создавать картинки неотличимые от оригинальных. ??????. Profit.

Kaggle: Digit Recognizer (MNIST) точность 0.99585

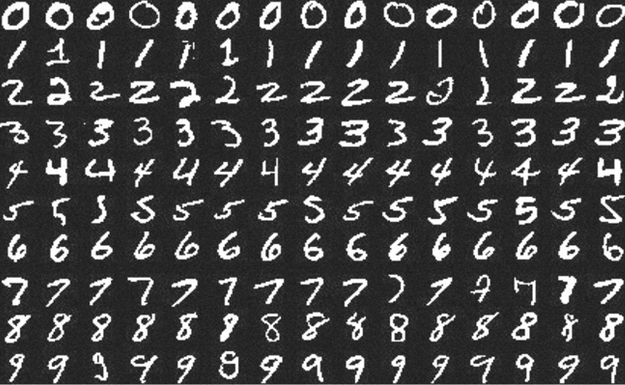

Примеры цифр из набора MNIST.

Продолжаю путешествие по занимательным землям Deep Learning.

В прошлый раз я учился заводить deep learning на локальной машине и делал совсем детскую, искусственную и неспецифическую для DL задачу.

В этот раз решил попробовать что-то более диплёрничное — научиться решать задачи на Kaggle. Есть предположение, что Kaggle — самый простой и интересный способ учить DL.

На этом сервисе есть задачи для новичков, одну такую — Digit Recognizer — я выбрал для тренировки. Соревнование по распознаванию рукописных цифр из набора MNIST. Этот набор должны были встречать даже люди далёкие от ML.

Notebook с решением и комментариями опубликован на github.

На момент отправки решение занимало 467 место из ~7000. На мой взгляд неплохой результат, учитывая, что первые мест 150 занимают читерские решения. MNIST — общедоступный набор данных, их можно скачать вне kaggle и залить в качестве решения готовые ответы, или переобучить сеть на полном наборе.