Глупые прогнозы об Искусственном Интеллекте

DALL-E: Wrubel painting: silly predictions about artificial intelligence

Пару месяцев назад начал делать заметки на тему поста с намерением не спеша накопить к лету и опубликовать. А тут некоторые прогнозы сбываться начинают :-D Поэтому закину что есть, без сроков и гарантий.

База для прогнозов:

- История развития ИТ;

- Понятие о подрывных технологиях, которой без сомнения является ИИ.

- Здравый смысл, как бы смешно это не звучало, исходя из названия эссе.

Поскольку даты для для прогнозов не указываю, можно считать их скорее трендами, направлениями эволюционного давления, чем конкретными событиями.

Реализация Generative Adversarial Network

В завершение разбирательства с Deep Learning решил посмотреть что-нибудь более интересное и ориентированное на генерацию контента — реализовать GAN.

По правде говоря, большую часть времени с GAN (и Autoencoder) я экспериментировал на спрайтах карты Сказки. Ожидаемо, на таком мизере обучающих данных ничего интересного не получилось. Хотя польза и была. Поэтому для поста я подготовил отдельный notebook с более наглядными результатами — генерацией обуви по набору данных Fashion MNIST.

Ноутбук с реализацией GAN и комментариями.

Про архитектуру GAN лучше почитать в вики, интернетах или моём ноутбуке.

Краткая суть:

- Тренируются две сети: generator & discriminator.

- Генератор учится создавать картинки из шума.

- Дискриминатор учится отличать поддельные картинки от настоящих.

- Ошибка дискриминатора определяется качеством предсказания фейковости изображения.

- Ошибка генератора определяется качеством обмана дискриминатора.

Если правильно подобрать топологии сетей и параметры обучения, то в итоге генератор научается создавать картинки неотличимые от оригинальных. ??????. Profit.

Ссылки на курсы по Machine Learning & Deep Learning

Перед началом разбирательства с темой собрал для себя список курсов, которые могут быть интересны.

Публикую, чтобы не пропадал зря.

Только ссылки. Свои комментарии вырезал — в исходном виде они никому кроме меня не помогут :-)

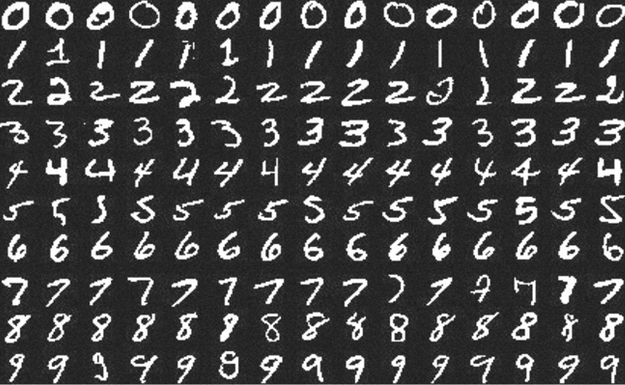

Kaggle: Digit Recognizer (MNIST) точность 0.99585

Примеры цифр из набора MNIST.

Продолжаю путешествие по занимательным землям Deep Learning.

В прошлый раз я учился заводить deep learning на локальной машине и делал совсем детскую, искусственную и неспецифическую для DL задачу.

В этот раз решил попробовать что-то более диплёрничное — научиться решать задачи на Kaggle. Есть предположение, что Kaggle — самый простой и интересный способ учить DL.

На этом сервисе есть задачи для новичков, одну такую — Digit Recognizer — я выбрал для тренировки. Соревнование по распознаванию рукописных цифр из набора MNIST. Этот набор должны были встречать даже люди далёкие от ML.

Notebook с решением и комментариями опубликован на github.

На момент отправки решение занимало 467 место из ~7000. На мой взгляд неплохой результат, учитывая, что первые мест 150 занимают читерские решения. MNIST — общедоступный набор данных, их можно скачать вне kaggle и залить в качестве решения готовые ответы, или переобучить сеть на полном наборе.

Просто о связи линейной алгебры и нейронных сетей

Нашёл серию статей с детальным рассказом о принципах работы нейронных сетей. Начиная от векторного произведения, через матрицы к персептрону и нейронам, Понятно, доступно и последовательно — без скачков через куски теории. С примерами на Python.

- Linear Algebra

- Inner Product Spaces

- The Perceptron, and All the Things it Can’t Perceive

- Neural Networks and the Backpropagation Algorithm

Остальной блог тоже интересен. У автора много вводных статей на математические и программистские темы.